Impressionen von der IFRA/DCX Expo in Berlin (9.-11.10.) und den Medientagen München (24.-26.10.)

Berlin/München, Oktober 2018. Künstliche Intelligenz (KI) und deren Bedeutung für Medien und Journalismus war das Hype-Thema sowohl der IFRA / DCX World Expo wie auch der Medientage München. Dabei geht es nicht um eine„starke“ künstliche Intelligenz, die sich mit den allgemeinen Problemlösungsfähigkeiten eines Menschen messen kann. Sondern vielmehr, für welche fachspezifischen Aufgaben eine „schwache“ künstliche Intelligenz absehbar heute schon eingesetzt werden kann. Im Fokus der beiden Veranstaltungen standen relevante Prozess- und Produktinnovationen in den Medien. Und natürlich die Frage, ob und wie künstliche Intelligenz Medien und Journalismus verändern wird.

Neuronale Netzwerke als Impulsgeber der KI

Nach dem Schub, den regelbasierte Systeme („Expertensysteme“) der KI in den achtziger Jahren gegeben hatten, stehen heute künstliche neuronale Netzwerke (artificial neuronal networks, ANNs) mit Mittelpunkt des technischen Fortschritts. Die Möglichkeiten solcher Systeme stützen sich insbesondere auf:

- die Leistungsfähigkeiten moderner Hardware wie Grafikprozessoren. Diese können die Operationen in den einzelnen Neuronen des Netzwerks massiv parallel abarbeiten.

- die Fähigkeiten des maschinellen Lernens, mit denen sich ein solches neuronales Netzwerk an vorgegebene Ein-/Ausgabemuster anpassen kann. In der Strukturierungsform eines neuronalen Netzwerks mit vielen verborgenen Zwischenschichten zwischen Ein- und Ausgabelayer ist ein solches Netzwerk insbesondere in der Lage, unbekannte Strukturen in den Eingabedaten selbstständig zu erlernen (»deep learning«).

Die Fähigkeit des maschinellen Lernens bedeutet eine in ihrer wirtschaftlichen Relevanz nicht unterzubewertende Effizienzsteigerung. Schon in den achtziger Jahren des letzten Jahrhunderts stand KI im Mittelpunkt des technischen Fortschrittes. Die Euphorie dieser Jahre war durch die neuen Möglichkeiten von regelbasierten Expertensystemen in den Einsatzfeldern Diagnose und Konfiguration geprägt. Der Preis dieses Erfolgs aber war ein hoher manueller Pflegeaufwand für das Expertenwissen. Sowohl für Akquisition und Pflege des zugehörigen, strukturierten Datenmodells wie auch der Inferenzregeln, mit denen Schlussfolgerungen aus den Daten abgeleitet werden. Dieser Pflegeaufwand war der Grund, warum sich solche Systeme nicht nachhaltig durchsetzen konnten. Der „KI-Winter“ der neunziger Jahre machte deutlich, dass die Pflege solcher Expertensysteme mit wirtschaftlichem Aufwand praktisch nicht möglich war.

Dies sollte heute beim Thema Roboter- bzw. Datenjournalismus nachdenklich stimmen, dessen Textgenerierung überwiegend auf einem regelgesteuerten Vorgehen beruht.

Maschinelles Lernen mit neuronalen Netzwerken

Thomas Ross, IBM Global Services, wies in seinem Referat auf den Medientagen München darauf hin, dass eine Genauigkeit in den Ergebnissen von ANNs, die über 70% hinausgehen, heute nur mit anwendungsspezifischem, typischerweise auch vertraulichem, unternehmenspezifischem Trainingsbeispielen und Wissen erzielt werden kann. In diesem Kontext gewinnt die Frage, wem denn diese Daten gehören, natürlich an Bedeutung.

Um ANN Qualitätsergebnisse von 90% und mehr zu erreichen, ist die Verwendung des überwachten Lernens heute der Regelfall. Dabei werden von Menschen bewertete, paradigmatische positive wie negative Trainingsbeispiele eingesetzt. Ein unbeaufsichtigtes (selbst)bestärkendes Lernen von ANNs ist eher noch Zukunftsmusik. Bei dieser Lernform würde ein ANN seinen Output eigenständig als besonders zutreffend bewerten und seine interne Netzwerkstruktur entsprechend anpassen. KI-Leuchttürme wie Google’s AlphaGo Programm, das 2016 erstmalig einen der weltbesten menschlichen GO Brettspieler schlagen konnte, weisen allerdings genau in diese Richtung. Das KI-System verwendet zwei ANNs, jeweils eines um den nächsten Zug zu generieren („policy network“), und eines, um die Spielposition zu bewerten („value network“). Seine Spielstärke gewann das System, indem es mehrere Millionen Spiele gegen sich selbst spielte und dabei seine Strategie erlernte.

Anwendungsfelder künstlicher Intelligenz in den Medien

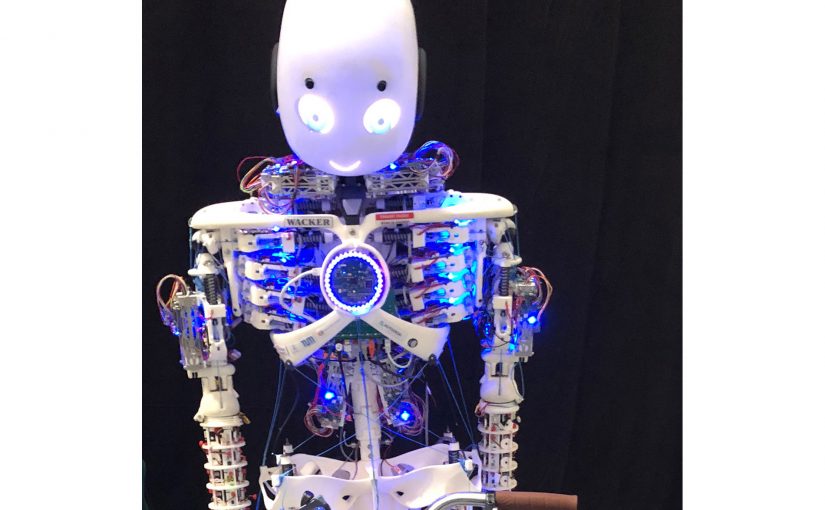

Im Bereich der Medien zeichnen sich heute vier Einsatzbereiche für künstliche Intelligenz ab. Drei dieser Einsatzbereiche sind Anwendungen von ANNs. Natürlich ist KI als Wissenschaftsdisziplin deutlich mehr als ANNs und maschinelles Lernen. Wie weit der Weg zu praxisgerechten Produkten in der Robotik ist, verdeutlichte ungewollt der humanoide Roboter Roboy 2.0 der Technischen Universität München bei der Präsentation auf den Medientagen (siehe Bild). Infolge einer mechanischen Störung des Kopfes versagte er schon in der Grundvoraussetzung einer wirkungsvollen Kommunikation, seinen Gesprächspartner während des Gesprächs anzusehen.

I Prädiktive Wartung in der Drucktechnik

Dieses Zukunftsthema des gesamten Maschinenbaus beherrschte die IFRA / DCX Expo in Berlin. Durch die Digitalisierung und Vernetzung stehen heute vielfältige sensorische Daten von allen technischen Komponenten eines Drucksystems zur Verfügung. Die Integration und Verdichtung dieser Daten lässt einen bevorstehenden Ausfall eines Drucksystems schon im Vorfeld erkennen. Technisches Instrument ist ein ANN, das die Sensordaten (Eingabeschicht ANN ) und das daraus ableitbare, wahrscheinliche Störungspotenzial (Ausgabeschicht ANN) in Beziehung setzt. Das ANN verdichtet idealtypisch die verfügbaren Daten und Erfahrungen mit allen Drucksystemen dieser Bauart von allen Einsatzorten. Die prädiktive, bedarfsgesteuerte Wartung auf Basis einer solchen ANN Analyse ist kosteneffizienter als eine präventive Wartung, die Komponenten rein vorsorglich erneuert. Und sie ist deutlich attraktiver als eine ungeplante Wartung, Reparatur, nach Ausfall des Drucksystems, die mit inakzeptablen Stillstandszeiten des Drucksystems einhergeht. Fachleute gehen davon aus, dass zukünftig 80% der Wartung von Drucksystemen von entsprechend spezialisierten Dienstleistern durchgeführt wird, und die Verlage höchstens noch 20% der Wartung, typischerweise die Reparaturen in Notfallsituationen, selber vornehmen.

II Inhaltserschließung von Texten, Bild- und Videodaten

Die KI-basierte automatische Inhaltserschließung von Bild- und Videodaten bietet für die redaktionelle Arbeit wahrnehmbare Effizienzsteigerungen. Für Texte beinhaltet dies die textuelle Erkennung von Personen, Objekten und Orten des Geschehens, von denen im Text die Rede ist (»entity extraction«). Dies ermöglicht es, dem Text passende verwandte Artikel, Bilder und/oder Werbung zuordnen zu können. Dieser Service wurde und wird von den großen Suchmaschinen (wie FAST) schon seit einer Dekade zu Premiumpreisen angeboten und erforderte einen hohen Pflegeaufwand. Der Service ist jetzt für einen Bruchteil der Kosten möglich (siehe auch unten den Abschnitt: Demokratisierung der Künstlichen Intelligenz). Neu hinzu gekommen sind jetzt mit KI Unterstützung die Motiverkennung in Bildern und Videos sowie die visuelle Erkennung von bekannten Personen des öffentlichen Lebens (»celebrities«). In der Summe bieten die KI-Techniken eine wesentlich reichhaltigere, automatische Zuordnung von Metadaten zu Texten, Bildern zu attraktiven Preisen und entlasten den Redakteur/Reporter von dieser Aufgabe. Für Sportvideos ist mit KI Verfahren eine automatische Verdichtung des Inhaltes auf die spielentscheidenden Szenen möglich. Der Filmproduzent UFA setzt neuronale Netzwerke etwa für die automatische Übersetzung und Untertitelung von Serienvideos in sehr viele andere Sprachen ein. Eine manuelle Synchronübersetzung solcher Serienvideos wäre aus Kostengründen überhaupt nicht wirtschaftlich.

III Inhaltsgenerierung, Datenjournalismus

Die datengesteuerte, automatische Generierung von Wetterberichten, von Sportberichten (z.B. im Breitensport, Washington Post’s Heliograf) und von Unternehmensberichten (z.B. Bloomberg) nimmt aus Kostengründen einen immer breiteren Raum im Journalismus ein. Bei Bloomberg enthält schon ein Viertel aller Texte in den Produkten des Unternehmens automatisch generierte Inhalte. Die ethische Frage, ob solche Berichte explizit als Roboter- bzw. Datenjournalismus gekennzeichnet werden sollten, wurde auf den Medientagen München im Panel zu KI und Meinungsbildung, -vielfalt kontrovers diskutiert.

IV Personalisierter Inhalt und Service

Die Personalisierung von redaktionellen Inhalten und werblichen Angeboten sind heute eine der unstrittigen Stärken von Amazon, Facebook, Netflix, … . Die Personalisierung erfolgt auf Basis eines mit KI-Verfahren erstellten individuellen Interessensprofils für jeden Nutzer dieser Dienste. Für Facebook wird diese Profilbildung und -verwendung von dessen KI-Chef Yann LeCun in einem aktuellen Interview [1] plastisch und detailliert beschrieben. In den Medien dominiert Netflix den Einsatz von KI-Verfahren zur Personalisierung seiner Angebote; das Thema gewinnt aber auch gerade für personalisierte elektronische Programmführer (EPG) für Hörfunk und Fernsehen zunehmend an Bedeutung.

Eine besondere Bedeutung haben natürlichsprachliche Chatbots im Kundenservice. Sie können heute nicht nur die typischen Anfragen und Beschwerden von Kunden erkennen, im Dialog verarbeiten und das Notwendige veranlassen. Die KI kann auch die aktuelle Gefühlslage eines Kunden aus seiner Sprache erkennen. Sie kann dann entsprechend korrektiv reagieren. Oder einen menschlichen Service Agenten entsprechend informieren, an den das Gespräch nach Klärung des grundsätzlichen Kundenanliegens weitergereicht wird. Typischerweise wird der Chatbot auf Basis des individuellen Kundenprofils das Gespräch steuern. In dieses Profil fließen die Historie der Kundenbeziehung und die erkannte Gefühlslage des Kunden aus dem aktuellen Gespräch ein. Insbesondere wird das Kündigungsrisiko ermittelt. Durch eine entsprechende Tonalität und Konzessionsbereitschaft des Gesprächs sowie spezifische Angebote versucht der Chatbot, eine solche Kündigung möglichst zu vermeiden.

Demokratisierung der Künstlichen Intelligenz

Unter diesem Motto bieten die großen Plattformbetreiber wie Amazon, Google, … pay-per-use Services für einen einfachen Zugang zu KI-Technologien an. Amazon’s AWS bietet etwa den Zugriff auf KI Technologien in drei Ebenen an. Application services erlauben die Verwendung von vortrainierten neuronalen Netzwerken für Bilder und Sprache. Sie sind ohne Kenntnisse der dort eingesetzten KI Technologien durch Kunden zu verwenden. Die Ausgangsdaten müssen aber stets zuvor in die S3 Cloud des Anbieters geladen werden.

- Für Bilder und Videos leisten die Services eine Inhaltserschließung durch Generierung von Metadaten. Weiter können Personen und Texte in Bildern erkannt und in Videostreams verfolgt werden, inklusive der Erkennung bekannter Persönlichkeiten des öffentlichen Lebens.

- Die Sprachservices bieten eine Erkennung gesprochener Sprache, Inhaltserschließung (»entity extraction«), Erkennung der Gefühlslage (sentiment) des Sprechenden, Übersetzung, Generierung gesprochener Sprache und die Konfigurierung von Chatbots an. Diese Services kommen auch für die Echo/Alexa Produkte des Anbieters zum Einsatz.

Die AWS application services nutzen intern die AWS platform services. Diese erlauben dem KI-Experten bzw. Datenwissenschaftler die Erprobung und Konfiguration spezifischer Algorithmen und Modelle des maschinellen Lernens für künstliche neuronale Netzwerke. Wer sich selber auch um die massiv parallele KI-Hardware der neuronalen Netzwerke kümmern möchte, kann direct die AWS framework and infrastructure services nutzen und einen skalierbaren Verbund von NVDIA Grafikprozessoren steuern. Nutzungsgrundlage ist ein hochflexibles Mietmodell für die entsprechende Hardware.

Neben der Zugänglichkeit von KI-Technologien stellen die Ausgewogenheit und Kontrolle der Schlussfolgerungen ein weiteres Problemfeld dar.

Die Schlussfolgerungen, die ein künstliches neuronales Netz gemäß seinem erlernten Wissen aus Eingabedaten abgeleitet hat, sind ein Ergebnis a) der Trainingsdaten und b) der Verarbeitungsalgorithmen in den einzelnen Neuronen. Eine Erklärungsfähigkeit dieser Schlussfolgerungen ist damit praktisch kaum gegeben. Es gibt insbesondere eine deutliche Abhängigkeit dieser Schlussfolgerungen von der Qualität und Ausgewogenheit der Trainingsdaten [2].

Es ist aber bei Weitem nicht nur für den Journalismus relevant, wie Schlussfolgerungen von KI-Systemen zustande kommen. Die Verwendung solcher Systeme im US Justizsystem etwa für die Strafzumessung und Strafaussetzung zur Bewährung verdeutlicht die Risiken [3].

Künstliche Intelligenz (KI) als Schlüsseltechnologie des 21. Jahrhunderts

Es ist eine zunehmend verbreitete Einschätzung, dass künstliche Intelligenz eine der Schlüsseltechnologien des 21. Jahrhunderts sein wird. Man sollte sich aber über den aktuellen Stand des Einsatzes dieser Technologie im Alltagsleben keinen Illusionen hingeben. Vor wenigen Tagen stürzte eine nagelneue Boeing 737 Max in Indonesien ab – offenkundig wegen technischer Probleme [4]. 189 Menschen verloren ihr Leben. Boeing bietet für die Maschinen dieser Bauart sein „Onboard Network System (ONS)“ an. Unter Verwendung einer Satellitenverbindung zum Flugzeug ist mit ONS in Echtzeit eine Analyse der aktuellen technischen Daten des Flugzeuges sowie eine prädiktive Analyse fehlerhafter Aggregate der Maschine möglich. Das ONS realisiert damit auch eine Echtzeit „Black Box“ des Flugzeuges. Das System war bei der Fluglinie (aus wirtschaftlichen Gründen) nicht in Verwendung. Nach einer der beiden Aufzeichnungsgeräte, die für die Unfallaufklärung von größter Wichtigkeit ist, wird bis heute vergeblich gesucht. Sie ist vermutlich beim Aufschlag des Flugzeuges auf die Meeresoberfläche unwiderruflich zerstört worden. Unter anderem wehren sich Pilotenverbände gegen eine laufende Überwachung ihrer Maschinen – und damit Ihrer fliegerischen Tätigkeit. Künstliche Intelligenz hat also noch mit deutlichen Akzeptanzproblemen in der Praxis zu kämpfen. Selbst dann, wenn es um Hunderte von Menschenleben und Investitionsgüter in mehrstelliger Millionenhöhe geht.

Bei einer Befragung von Bürgern Deutschlands, Frankreichs, Spaniens, der USA, Großbritanniens, Kanadas und China war die Ablehnungsquote von künstlicher Intelligenz mit 20% in Deutschland von allen Ländern am höchsten, mit 2% in China am niedrigsten (USA, Großbritannien, Frankreich, jeweils: 10%, 12%, 14%).

In China besitzt das Thema künstliche Intelligenz einen strategischen Stellenwert in der wirtschaftlichen Entwicklung [5]. Der chinesische Staat sieht die Zukunftstechnologie nicht nur als Eckpfeiler zur Sicherung seiner Position als zukünftige Supermacht. China möchte bis 2030 im Bereich der KI nicht nur eine technisch/wirtschaftliche Spitzenposition erreichen. KI wird dort auch in einer politischen Dimension als geeignete technologische Basis zur flächendeckenden Überwachung der Bevölkerung und Sicherung der Stabilität des politischen Systems gesehen. Ob dies in einer einzigartigen „Daten Diktatur“ münden wird, wie es die „Welt“ visionär voraussieht [6], bleibt der Einschätzung des Lesers überlassen. Nach einer Prognose der OECD [7] werden im Jahr 2030 jedenfalls etwa 37% der Hochschulabsolventen aus den OECD/G20 Staaten in den relevanten KI-Wissenschaftsfächern Informatik, Mathematik, den Natur- und den Ingenieurwissenschaften aus China kommen. Die USA und Russland steuern noch ca. 4,5% der Absolventen bei, Deutschland ganze 1,4%!

Entrepreneurial Journalism

Neben dem Thema KI waren die Medientage München natürlich durch Diskussionen zu aktuellen Fragen des Journalismus geprägt. Der bekannte amerikanische Medien-Vordenker Prof. Jeff Jarvis erläuterte seine neue (Aufgaben)Definition von Journalismus: „convene communities into civil, informell, and productive conversation“. Er bekannte, dass seine bisherige These, dass die Zukunft des Zeitungsjournalismus im hyperlokalen Blogging und entsprechender Berichterstattung zu sehen sei, ein Fehler war.

Jarvis plädierte stattdessen jetzt für einen »entrepreneurial journalism«, der Märkte und Nutzer besser als bisher versteht. Dabei stehen sowohl die gezielte Entwicklung des journalistischen Produktes, aber auch der Nutzer- / Lesergemeinde, gleichwertig im Vordergrund. „Story telling“ als zentrale journalistische Mitteilungsform sei wichtig, aber nicht genug. „We desperately need new advertising models, based on value, not attention. Trust matters more than ever.“ Und den (deutschen) journalistischen Startups hielt Jarvis vor, zu sehr mittelständisch zu denken, „but, you need to conquer the world“. Jarvis sieht hier noch deutliche Chancen für die digitalen Medien mit seiner zentralen These: „In Gutenberg time, the internet is very young, premature, and not yet understood by media!“

Dominanz der Plattformen

Die zentrale Wichtigkeit von Plattformen zur Ausspielung digitaler Medienprodukte ist unbestritten. Die erdrückende Macht der Plattformbetreiber Google/Alphabet, Apple, Facebook, Amazon (GAFA) liegt insbesondere darin, dass sie exklusiv den Kundenzugang verwalten und die Nutzungsgewohnheiten auswerten. Letzteres wiegt im Zeitalter der KI besonders schwer, siehe auch [1]. Von daher kreiste die Diskussion der Medientage München darum, ob deutsche Medienunternehmen hier überhaupt mehr als eine Anpassungs- oder Ausweichstrategie realisieren können? Die bisherigen Antworten der Medienunternehmen sind der Aufbau neuer Geschäftssparten außerhalb des GAFA Produktportfolios, wie die Rubrikenportale von Springer und Bewertungsplattformen von Burda. Die Effizienzplattform der Ippen Gruppe wurde von Chefredakteur Thomas Kaspar vorgestellt.

Medientage München 2018

Die Plattform stützt sich auf standardisierte Inhaltsformate, eine eigene Empfehlungstechnologie sowie eine Zentralredaktion als Service für alle Plattformpartner, um eine möglichst hohe Reichweite erzielen zu können. Für den Leser relevante, substanzielle und nachprüfbare Inhalte stehen im Vordergrund. Zur Realisierung einer hohen Reichweite muss sich die Gestaltung der journalistischen Produkte an den technologischen Rahmenbedingungen der Plattform und einer Fokussierung auf die Nutzungszahlen orientieren. „Nutzer nehmen Inhalte, die ihre Probleme lösen!“ Von daher gewinnt das Thema Content Marketing für solche Portale zunehmend an Bedeutung.

Den Leser erreichen, aber nicht erziehen!

Das Thema political correctness bestimmte den Inhalt des abschließenden Journalismusgipfels der Medientage. Der eingeladene ORF Chefredakteur TV-Information Dr. Armin Wolf verdichtete das Thema in seinem Impulsreferat beispielhaft an der Verwendung des Begriffs „Neger“. Dieser Begriff ist, nach übereinstimmender Überzeugung nicht nur der Teilnehmer der Podiumsdiskussion, natürlich nicht mehr zeitgemäß und zulässig. Alle mit dem Begriff Angesprochenen fühlen sich hierdurch angegriffen und bewusst in einen kolonialen Kontext gestellt. Andererseits findet ein Anteil von bis zu 30% der Bevölkerung den Begriff „Neger“ durchaus noch verwendungsfähig. Dieser Bevölkerungskreis wird durch die heutigen Medien typischerweise nicht mehr erreicht; die Medien werden in diesen Kreisen als Lücken- oder Lügenpresse wahrgenommen. Mit der klassischen Definition von Qualitätsjournalismus als Angebot an die Vernunft der Leser – gegenüber anderen journalistischen Formen, die eher auf die Emotionen der Leser setzen – ist es nicht getan. Für die entsprechenden Bevölkerungsgruppen findet sich deren Lebensrealität nicht mehr ausreichend in den Medien abgebildet. Die selbstkritische Frage des Podiums war, ob relevante Themen nicht intensiv genug recherchiert werden, wenn es im Ergebnis „Beifall von der falschen Seite“ geben könnte? Auch der demokratische Erziehungs-/Bildungsauftrag, den die Alliierten nach dem Zweiten Weltkrieg mit der Vergabe von Zeitungslizenzen an die Verleger klar verbunden haben, könnte heute noch auf eine zu „staatstragende“ Berichterstattung und Bewertung Einfluss nehmen. Übereinstimmung auf dem Podium herrschte darüber, dass Inhalte immer aus einer Haltung heraus entstehen. Und es gehört zu den Grundprinzipien des journalistischen Handwerks, Recherche/Aufklärung, Bericht und Bewertung klar – und in dieser Reihenfolge – voneinander zu trennen. Was aber, wenn klar berichtete Fakten von den Rezipienten nicht mehr geglaubt und in ihr Gegenteil verdreht werden (»alternative Wahrheiten«)? Argumente nicht mehr nur als falsch, sondern „böse“ empfunden werden? Da waren auch die Teilnehmer des diesjährigen Journalismusgipfels am Ende ihrer Weisheit. Das Thema dürfte also in den nächsten Jahren weiter aufgegriffen werden.

Referenzen

[1] Alexander Armbruster: KI Superstar CeCun im Gespräch: „Ohne KI funktioniert Facebook nicht“ FAZ.net vom 6.11.2018

[2] Eva Wolfangel: Google und die Frau am Herd – Weshalb künstliche Intelligenz anfällig ist für Rassismus, Rollenklischees und Vorurteile, Zeit Online vom 12.07.2017, Die Zeit Nr. 29 / 2017

[3] Jason Tashea: Courts are using AI to sentence criminals. That must Stop now. WIRED vom 17.04.2017

[4] Gerhard Hegmann: Flugzeugabstzürze / Die Suche nach der Blackbox ist eine technische Farce,Welt vom 06.11.2018

[5] S.Hua et al.: Das Große Rennen um künstliche Intelligenz – Wie China bei der Technologie der Zukunft zur Supermacht aufsteigt, Handelsblatt Wochenende Special vom 26.10.2018, pp.56-66

[6] Johnny Ehrling: Daten Diktatur / „In China entsteht, was wir noch nie gesehen haben“, Welt+ vom 30.10.2018

[7] Aus diesen Ländern stammen die Ingenieure der Zukunft, Manager Magazin vom 11.05.2015

Ein Gedanke zu „Medien und Künstliche Intelligenz (KI)“